Questa AI si scrive da sola. Ah, no?

Invece di parlare di AI in modo inclusivo e concreto...parliamo di fantascienza?

Ciao!

Voglio impegnarmi a far arrivare il prossimo numero entro due settimane, vediamo. Oggi tutte cose AI, ma in cui parlo anche a persone non appassionate di AI giuro:

Elon Musk e Rishi Sunak, premier UK, si sono incontrati per l'AI Safety Summit, ed è stato un disastro

Le peripezie di OpenAI ci dicono che l'AI non si autoregola è che c'è un problema di inclusione

L'unico sconto che vi consiglio per il Black Friday (not sponsored). Perché le offerte sono stancanti

Che differenza c'è tra una Tesla e un robot? Nessuna, per Musk

A inizio mese c'è stato in UK un summit sull'AI (un mio post su Datapizza con un mini recap), fortemente voluto dal premier Rishi Sunak, e in esso c'è stato un incontro tra Sunak ed Elon Musk, il complottista del nostro cuore ❤️.

(Giuro che non vi sto per parlare di robe politiche noiose).

Vi invito caldamente a non guardarlo: sarebbero 50 minuti buttati della vostra vita. L'ho fatto io per voi e vi racconto i miei pensieri.

Il personaggio di Musk ormai lo conosciamo. Ne abbiamo parlato in numeri precedenti:

Quello che è sempre più sorprendente per me è come venga preso seriamente 'at face value' senza una visione critica di quando dice delle assurdità.

Nell'incontro infatti vediamo Sunak completamente ammaliato e quasi asservito a un ricchissimo imprenditore.

Sunak più che un primo ministro di un paese importante sembra il presentatore di un talk show entusiasta di incontrare il suo idolo.

Questo purtroppo lo trovo in linea con alcune dichiarazioni catastrofiste di Sunak prima del summit, che riprende un po’ la linea dei cosiddetti ‘doomer’ per l’AI, ovvero chi vede nello sviluppo dell’AI e dell’AGI (Artificial General Intelligence) un rischio ‘esistenziale’: l’intera umanità, dicono, potrebbe estinguersi a causa di AI superintelligenti.

Forse Sunak non si spinge agli estremi di questa ipotesi, che io trovo problematica (magari prossima volta ne parliamo di più così vi spingo all’iscrizione eheh), ma chissà.

Pensiamo un attimo alla situazione: siamo a un summit per parlare di regolamentazione internazionale sull'AI, di come muoversi e di come trovare. Una situazione che richiederebbe grande concretezza.

Ecco, il framing che propone Musk dall'inizio è quello di un fantascientifico futuro in cui le AI possano fare tutto e siano sull'orlo di una superintelligenza artificiale.

Questo inquadramento è la questione centrale e più problematica dell'intero incontro.

Si parla solo del futuro.

Non di un futuro prossimo però, ma di un futuro vago, intangibile, da sognatori.

E si dimentica completamente il presente.

Quando Sunak chiede: 'dobbiamo preoccuparci che l'AI ci rubi il lavoro?'

La risposta di Musk è il copione di un film sci-fi: 'arriveremo a un momento in cui nessun lavoro è necessario' e da lì si parte a parlare di come daremo senso alla vita,

di un reddito di base universale,

un futuro di abbondanza

e ci mancava solo ficcare la pace nel mondo.

Non fraintendetemi, è affascinante pensare a un ipotetico futuro in cui tutti possono non lavorare, ma se ne parliamo in un contesto politico che deve guidare delle policy concrete su come agire oggi, stiamo saltando molti step.

E nel farlo stiamo facendo il gioco di quelle poche aziende che si vogliono arricchire senza ostacoli.

Prima di arrivare a quel futuro dobbiamo affrontare la grande complessità dell'impatto delle AI nel mondo di oggi, e di tutte le lacune che ha.

I sistemi AI che abbiamo sono tutt'altro che magie sull'orlo di essere intelligenti come un certo marketing ci vorrebbe far credere.

È come se il tuo personal trainer che ti deve allenare per una maratona invece di darti esercizi ti dicesse solo 'beh ma pensa quando avrai vinto, che figata no?'. Grazie Musk, molto utile.

Il mio takeaway è questo: difendiamoci dall'hype sregolato.

Chi parla solo di fantascienza da queste grandi aziende spesso guadagna direttamente da una narrazione che dipinge questi sistemi come molto più potenti e senza falle di quanto non siano realmente.

Vi faccio un ultimo esempio: verso la fine arriva una domanda:

'Per questa età dell'abbondanza ci serviranno robot.

A cosa dobbiamo pensare in termini di limitazioni, riguardo il rischio che un paese rimanga molto indietro dall'entrare in questa era?'

La risposta di Musk è esilarante:

'Beh, qualsiasi cosa che ha un computer di fatto è un robot, quindi le Tesla sono robot a 4 ruote, questo è un vantaggio perché non ci possono rincorrere dentro gli edifici e se creiamo robot umanoidi dobbiamo fargli un pulsante off locale per sicurezza'

Ok Elon, faremo gli EVA con il cavo, che ti devo dire.

OpenAI è così confusa da colpirsi da sola

Probabilmente avete sentito che ci sono stati un po' di casini in OpenAI:

Sam Altman, il CEO, è stato licenziato dal board,

poi è entrato in Microsoft come CEO di una divisione sulla ricerca AI,

poi è tornato CEO di OpenAI,

e il board è stato cambiato.

Tutto più o meno nel giro un weekend.

Non voglio parlare della vicenda in sé, ma di due problemi che il drama di OpenAI evidenzia.

TL;DR: OpenAI non ha saputo gestire se stessa e vuole gestire l'AGI? dai su.

E poi, bella questa nuova board di soli uomini.

Primo punto: OpenAI e la sua board dovevano essere quelli che ci avrebbero detto quando saremmo arrivati all'AGI, quelli che si dovrebbero assicurare che ciò venga fatto in modo 'sicuro'.

Quello che è successo è che non sono nemmeno stati in grado di gestire il proprio CEO, e ad oggi di fatto nessuno sa ancora la motivazione dietro il (breve) licenziamento di Altman.

Non erano nemmeno in grado di gestire i dipendenti di OpenAI, visto l'enorme supporto ad Altman della stragrande maggioranza dei dipendenti che se ne sarebbero andati senza Sam al comando.

(Anche se ci sono altre voci che ipotizzano che i dipendenti più senior abbiano fatto molta pressione agli altri).

Il mio takeaway è semplice: l'AI non si autoregola.

Le aziende che sviluppano i modelli, piccole (come OpenAI, nonostante l'enorme peso che ha) o grandi (Microsoft, Google, Meta) che siano, non possono avere il controllo sulla regolamentazione dei modelli e delle applicazioni AI.

Al di là dei conflitti di interessi, con questo drama da serie TV ci hanno mostrato che non hanno nemmeno la capacità interna di essere allineati. Non possiamo affidarci totalmente a loro.

Chiaramente la domanda che viene da farsi è...beh, se le sei persone del board non erano in grado di coordinarsi, come potrà mai farlo la politica internazionale? Eh, bella domanda.

(inserire commento su quello che sta succedendo all'AI Act; potete dare un'occhiata all'ultimo numero di Artifacts di Lorenzo Ancona:)

Secondo punto: il nuovo board di OpenAI, ad oggi, è composto da soli uomini, e non è un problema solo di forma.

OpenAI scrive 'a new initial board', e The Verge riporta che questa piccola board servirebbe a creare una nuova board di 9 persone per 'resettare' la governance di OpenAI, quindi è da vedere come sarà composta la board finale. Ma poi si dice il board o la board, a proposito di genere? Vabbè.

Sicuramente Microsoft vuole una posizione al suo interno, visto che Satya Nadella ha dichiarato di essere stato informato del licenziamento di Altman solo con un minuto di preavviso e che 'non voleva più sorprese'.

Specificare che siano solo uomini potrebbe sembrare solo una questione di forma per parlare di quote rosa in modo superficiale, ma penso rifletta un tema importante del mondo AI:

c'è un ampio gender gap nella ricerca e non solo, anche se diverse delle figure prominenti in tema di AI Safety, AI Ethics, e bias dell'AI sono donne: Gebru, Mitchell, Boulamwini, and the list goes on. (These Women Tried to Warn Us about AI, Rolling Stone)

Forse non è un caso: spesso sono le donne ad essere impattate maggiormente dall'AI in vari modi.

Abbiamo parlato un pochino di bias dell'AI in una scorsa lettera:

Ma abbiamo anche tanti esempi passati, per altre tecnologie, in cui la non inclusione di donne o minoranze abbia avuto effetti negativi.

Mi torna in mente l'intervento di Gaia Contu sulla non neutralità della scienza con un esempio calzante (in particolare da 14:15):

Ora, magari questa board ne sceglierà una permanente molto inclusiva, speriamo, ma mi permetto di avere dei dubbi.

Larry Summers, membro di questa board, nel 2005 fece un controverso intervento in cui ipotizzava che le donne abbiano delle differenze biologiche che le porta a non arrivare ad alti livelli nelle discipline STEM.

Ricordiamoci che la board no-profit di OpenAI non dovrebbe avere l'obiettivo di massimizzare i profitti ma quello dello “sviluppo sicuro di AGI”.

Però la domanda è...sicuro per chi?

Su questa domanda devo inserirmi anche io, purtroppo.

Sono stato invitato recentemente a dei tavoli di discussione su diverse sfaccettature dell’impatto dell’AI che volevano raccogliere diverse istanze ed expertise, dall'accademia all'industria, con l'obiettivo di confrontarsi e poi creare dei documenti da sottoporre al dibattito politico.

Penso che iniziative di questo tipo siano molto importanti e utili:

dobbiamo parlare insieme democraticamente dell'impatto delle tecnologie nelle nostre vite, ed è importante confrontarsi.

Beh...confrontarsi soprattutto tra uomini almeno, a quanto pare.

Purtroppo le donne erano meno del 10% nella composizione dei tavoli, e diversi tavoli erano composti solo da uomini, compreso quello a cui partecipavo.

Mi permetto di dare un po’ di beneficio del dubbio e pensare che magari qualche altra donna fosse stata invitata ma abbia scelto di non andare, ma il gap era veramente grosso…e il discorso generale rimane.

Se dobbiamo parlare alla politica di come vogliamo sviluppare l'AI per tutte e tutti, come possiamo farlo in modo equo selezionandoci in modo così stretto?

Non dico che bisognasse fare dei tavoli perfettamente rappresentativi della demografia italiana in ogni sfaccettatura, della serie che dovevi invitare x persone del nord, y del centro, z del sud, però almeno avere qualcosa di più rispetto ai soli uomini si poteva fare, visto che parliamo di politica, no?

Come accennavo prima, gli impatti dell'AI non sono 'equi'.

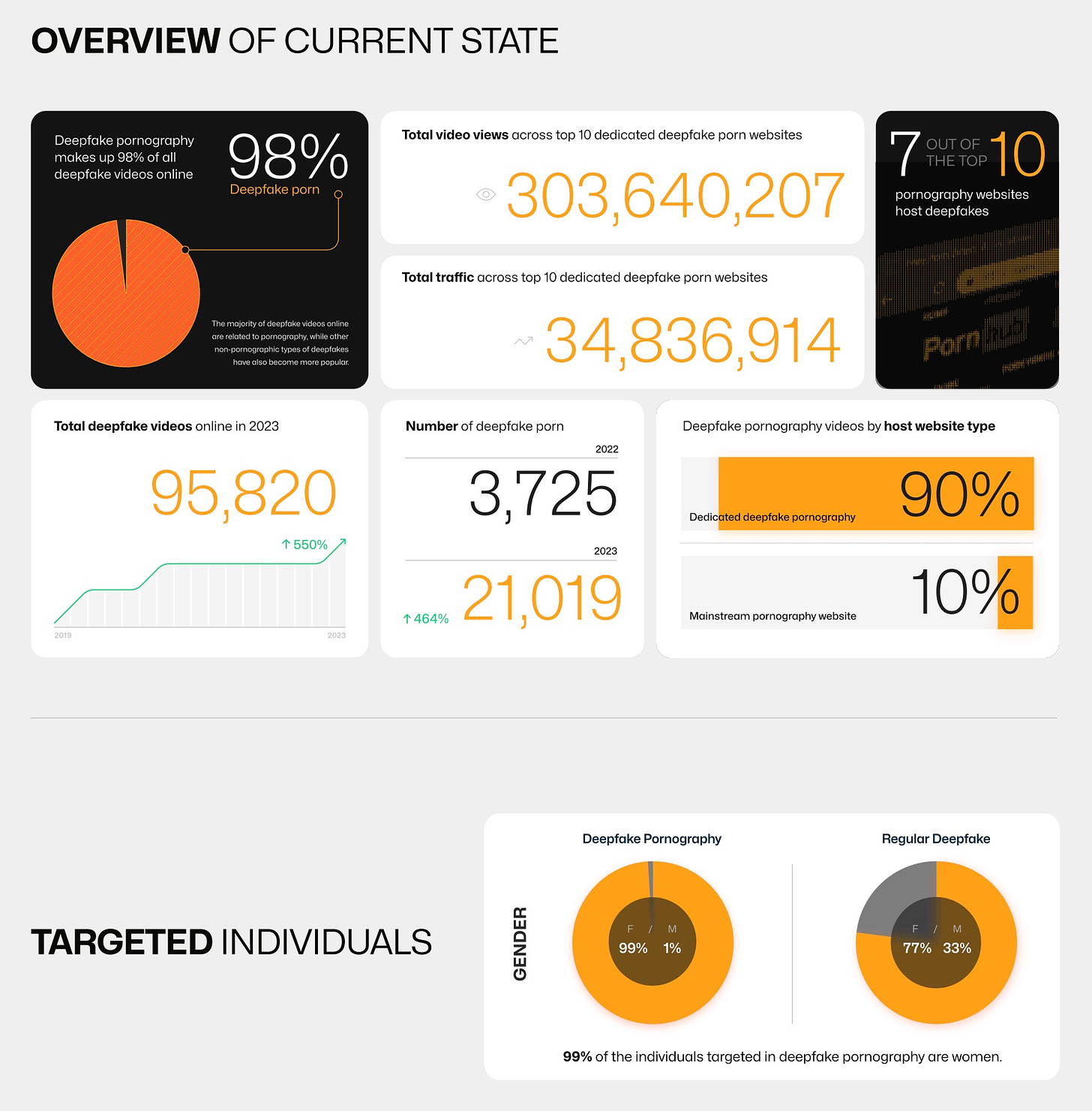

Si parla molto del problema dei deepfake e dei video generati da AI per i problemi di fake news, in particolare rispetto a figure politiche.

Non fraintendetemi, penso sia un problema reale a cui pensare, e diverse aziende stanno provando a creare dei watermark per contrassegnare i contenuti fake.

Ma la realtà è che i deepfake non vengono usati quasi mai per questo :)

Il report 2023 di Home Security Heroes sui deepfake riporta che il 98% dei contenuti deepfake online è pornografia non consensuale, e di questi contenuti il 99% ha come vittime le donne.

Forse nel 2024 questa proporzione potrebbe cambiare un po’, vista l’ondata di video deepfake ‘umoristici’, ma forse potrebbe semplicemente aumentare tutto l’uso di deepfake e non variare questa proporzione, chissà.

Diciamolo, di nuovo, che le tecnologie e i loro effetti non sono neutri, e tantomeno uniformemente distribuiti.

Non vorrei che da questa lettera sembri che io mi voglia mettere su un piedistallo come paladino dell’inclusione mentre gli altri sono infami: anzi, lo faccio perché sento di dovermi mettere io in primis più in discussione. Di mettermi più in ascolto dei problemi sistemici in cui anche io sono immerso.

Cosine belle (beh, insomma...)

Non mi posso esimere dall’attualità nei linkini di oggi:

📣 Elena Cecchettin, la sorella di Giulia Cecchettin, ha saputo esprimere con una grande lucidità la dimensione politica di ciò che è successo. Un pezzo su L'Essenziale di Annalisa Camilli che lo racconta.

❌ "Ma non tutti gli uomini", e altre 3 argomentazioni problematiche sulla violenza di genere su Valigia Blu da Claudia Torrisi, da leggere tutto soprattutto quando abbiamo dubbi a riguardo.

🔢 Di nuovo Internazionale eddai oh;

ci chiede: ma come si contano i femminicidi in Italia? I dati, come ci ricorda, non nascono da soli, qualcuno sceglie cosa raccogliere, come, e cosa non raccogliere.🗣️ Privacy Network si chiede (e chiede) la particolare posizione dell'Italia rispetto alle ultime trattative dell'AI Act: assieme a Francia e Germania, l'Italia sta ora chiedendo di non regolamentare i 'foundational models' come GPT. Vabbè sarebbe tutto un discorso lungo, ne riparliamo.

🧘 L’unico sconto che mi è interessato veramente per il Black Friday è quello di Headspace, una app di meditazione (che in realtà uso più spesso per dormire…).

Non so voi ma io sono veramente esausto dagli sconti, non ce la faccio a seguirli, voi?

Bene, e anche oggi ci siamo. Se ti è piaciuta questa lettera, la manderesti a qualcuno? O ne ricondivideresti una nota o un pezzo che ti ha colpito? Mi aiuta tanto ❤️.

Prossima volta parliamo...di come comunica riguardo Israele sui social? Oppure di rischio esistenziale delle AI, non so vediamo.

E come sempre, grazie per la lettura 👋.

In questa lettera manca una cosa, ci ho pensato; mo la aggiungo...