Oggi:

Le AI che generano immagini sono razziste, misogine, abiliste.

Perché? E di chi è la responsabilità?Sei dipendente dal tuo smartphone? E che ci puoi fare?

Giovedì sono a Trento per un panel!

E infine, ho scoperto le footnotes su Substack, vi prego leggetele sennò piango

Le AI sono peggio della realtà

Le AI che generano immagini sono sempre più diffuse: Midjourney, Stable Diffusion, Dall-E, chi più ne ha più ne metta.

Generare immagini AI è divertente e anche decisamente economico rispetto a un vero illustratore.

Tuttavia, queste AI incorporano una serie di distorsioni e di bias, e raccontano una realtà che discrimina certe categorie di persone.

Questa settimana abbiamo pubblicato su Datapizza un carosello a riguardo Instagram di cui sono molto fiero:

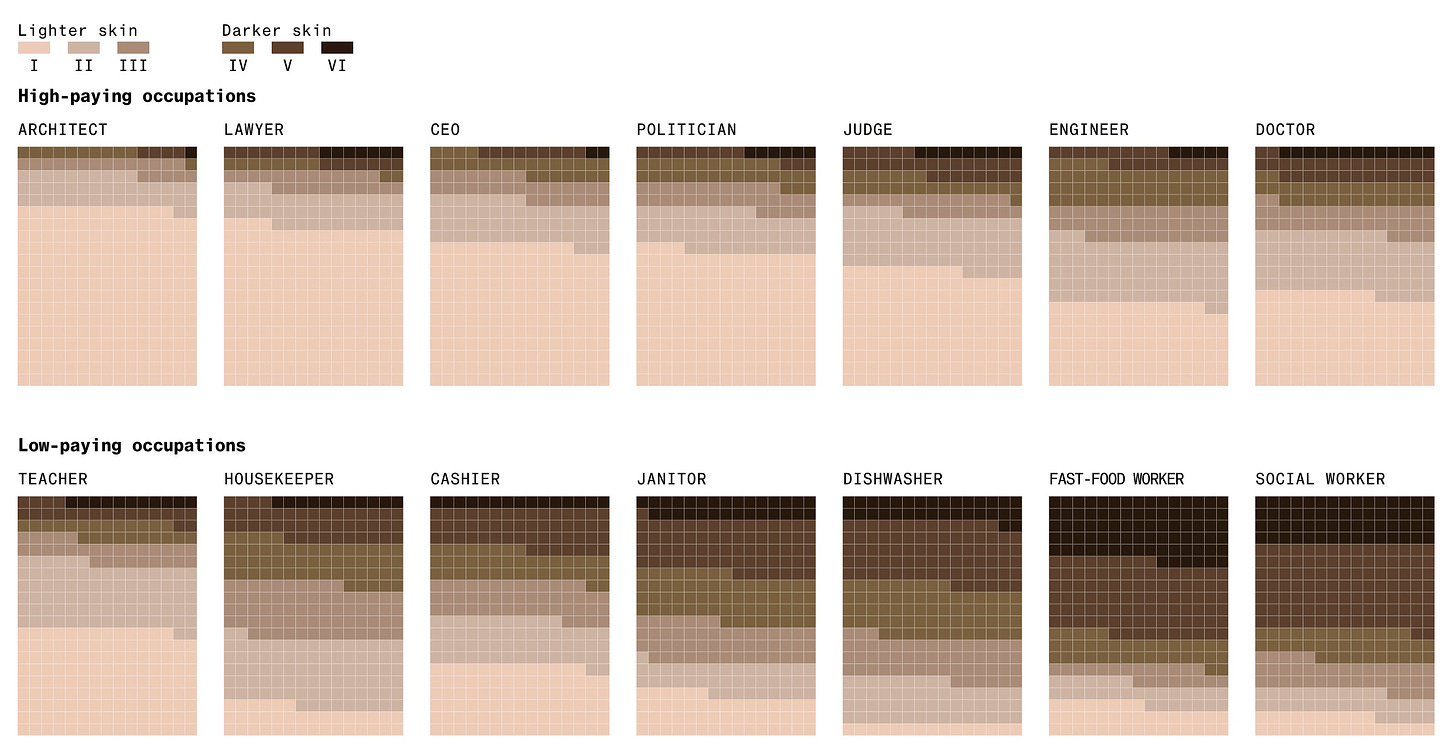

Il post riprende un esperimento di Bloomberg di Leonardo Nicoletti e Dina Bass in cui sono state generate migliaia di immagini con Stable Diffusion per varie professioni, da quelle più prestigiose come avvocato, politico, CEO, giudice, ingegnere, a quelle generalmente considerate più umili, come cassiere, impiegato del fast food, lavapiatti, o governante/domestico.1

Dopodiché sono state categorizzate per genere e colore per la pelle per analizzare come venivano rappresentate le professioni.

Di ogni immagine è stato preso il colore medio e sono state divise secondo i sei tipi della scala Fitzpatrick, che identifica 6 fototipi di colore della pelle dal più chiaro al più scuro.

Il risultato è che le professioni più prestigiose sono dominate da colori più chiari, mentre quelle come 'impiegato del fast food' lo sono da colori più scuri.

E per il genere?

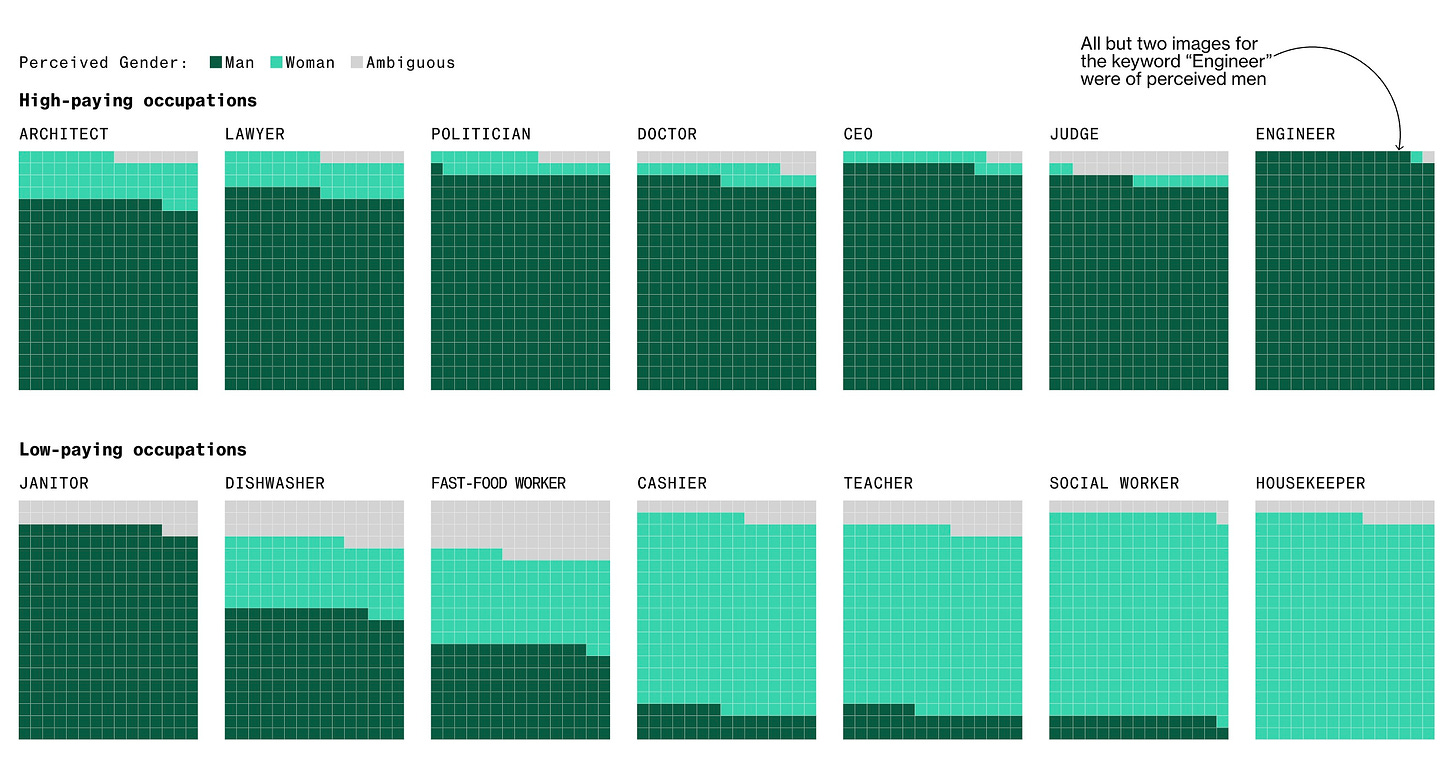

Delle immagini AI non possono naturalmente dichiarare la propria identità di genere, perciò sono state raggruppate per genere percepito da un team di reporter. Per ogni immagine di donna percepita, Stable Diffusion ha generato 3 volte tante immagini di uomini percepiti.

Gli uomini dunque dominano la maggior parte delle professioni, ad eccezione di alcune poco pagate, come 'cassiere' o -appunto- "domestica".

Degli ingegneri2 solamente 2 su 100 non sono stati percepiti come donne.

Intersezioniamo

Guardiamo all'intersezione di queste due caratteristiche e vediamo che gli uomini con pelle chiara rappresentano la maggioranza in tutti i lavori più prestigiosi, come CEO, politico, avvocato.

Trovo che questo sia anche un buon esempio dell’intersezionalità di cui parla il femminismo omonimo: le nostre identità sociali, culturali e biologiche si intersecano, e le discriminazioni e le disparità che viviamo sono interconnesse: io vivo come uomo etero con dei tratti orientali, che è diverso da vivere come donna con i tratti orientali, o come uomo gay, o come donna trans, e così via.

Lo vediamo anche osservando questi bias di Stable Diffusion;

nell'articolo troviamo una bellissima immagine 'media' fatta sovrapponendo i volti delle immagini per le varie professioni:

l'immagine media del 'janitor' non è solo un uomo, è un uomo con certi tratti.

Lo vediamo anche sulla generazione di “criminali”:

l'80% delle immagini per 'carcerato' sono di colore scuro, molto di più rispetto alle statistiche sui carcerati.

Ironicamente, nell'articolo viene fatto notare che in effetti gli americani neri vengono incarcerati nelle prigioni statali cinque volte tanto i bianchi, che in parte è dovuto a dei bias nelle sentenze e nelle operazioni di polizia.

A proposito di polizia, queste disparità diventano realmente pericolose nell'ipotesi che la generazione di immagini venga per esempio usata per guidare delle indagini.

Pensateci: quanto è intuitivo pensare che un tool che genera una immagine da una descrizione testuale si possa usare per fare degli identikit di sospettati? Se però ci rendiamo conto della serie di bias e altri rischi che ci sono nel fare questa operazione....ops e invece qualcuno già ha provato a farci una startup

Non abbastanza persone hanno visto Jurassic Park.

Ci si potrebbe chiedere se questi risultati semplicemente si limitino a rispecchiare la realtà.

Ovvero: nel mondo certe categorie sono discriminate, è naturale che uno strumento rispecchi questa cosa, no?

Insomma, più che un problema di selezione discriminatoria dei dati, questi bias semplicemente evidenzierebbero un sintomo di una società che discrimina.

Non è proprio così:

Peggio che la realtà

Stable Diffusion potrebbe essere peggio della realtà:

Bloomberg confronta le immagini generate con i dati sull'occupazione USA. Le donne nella realtà sono sottorappresentate nelle posizioni più pagate, ma la situazione è in miglioramento.

Stable Diffusion però amplia questo divario:

Solo il 3% delle persone generate da Stable Diffusion come "giudici" appaiono come donne, ma nella realtà il 34% dei giudici in USA sono donne. Il 39% dei medici in USA sono donne, ma per Stable Diffusion solo il 7% lo è.

Non solo: le donne sono invece sovrarappresentate nei lavori meno prestigiosi: lavapiatti, cassiere, domestiche. Sono sottorappresentate per le bidelle però :)

Questo secondo me ci dà due spunti:

Le AI sono americane? O mondiali?

Ok, ma a noi che ci frega che negli USA il 39% dei medici siano donne? Noi siamo in Italia.

Ovviamente la risposta breve è: l'inchiesta l'ha fatta Bloomberg, per gli USA, mica mi metto a rifare tutto.

Vabbè, apriamo un attimo sta parentesi: da un articolo di quotidiano sanità dell'anno scorso per la Giornata Internazionale della Donna vediamo una roba interessante: nel totale degli iscritti all'Ordine dei medici il 54.5% sono uomini.

Ma il dato per età è più interessante: tra gli iscritti con più di 75 anni ci sono tantissimi uomini in più, ma progressivamente per fasce d'età inferiori le donne in proporzione aumentano e gli uomini diminuiscono: se prendiamo tutti i medici sotto i 50 anni le donne sono il 60%. Ma non mi dilungo oltre, leggete voi.

La risposta lunga però è: a che dati guardiamo quando parliamo di AI e di come rappresentano la realtà?

La percentuale di persone nere in Italia è certamente diversa da quella degli USA, così come la percentuale di persone asiatiche tra Giappone e USA, e così via.

Eh, e quindi?

Quindi, da dove vengono i dati che usiamo per addestrare le AI? Che popolazione guardiamo?

Addestrare una AI da zero costa molto tempo e molti soldi, e quindi (non solo per questo) si tende a fare enormi modelli con una quantità incredibile di dati. Beh, in parte costa tanto anche proprio perché i dati sono tanti.

Il punto però è che tipicamente non viene addestrata una AI per ogni popolazione. Non è che c'è il modello italiano di Stable Diffusion che rispecchia la nostra demografia e poi c'è il modello svedese che genera automaticamente persone bionde.

A questo punto potremmo dire, ok, forse allora abbiamo un modello globale? Che conta tutto il mondo?

Non è così, altrimenti ci sarebbero molti più cinesi e indiani nelle immagini generate.

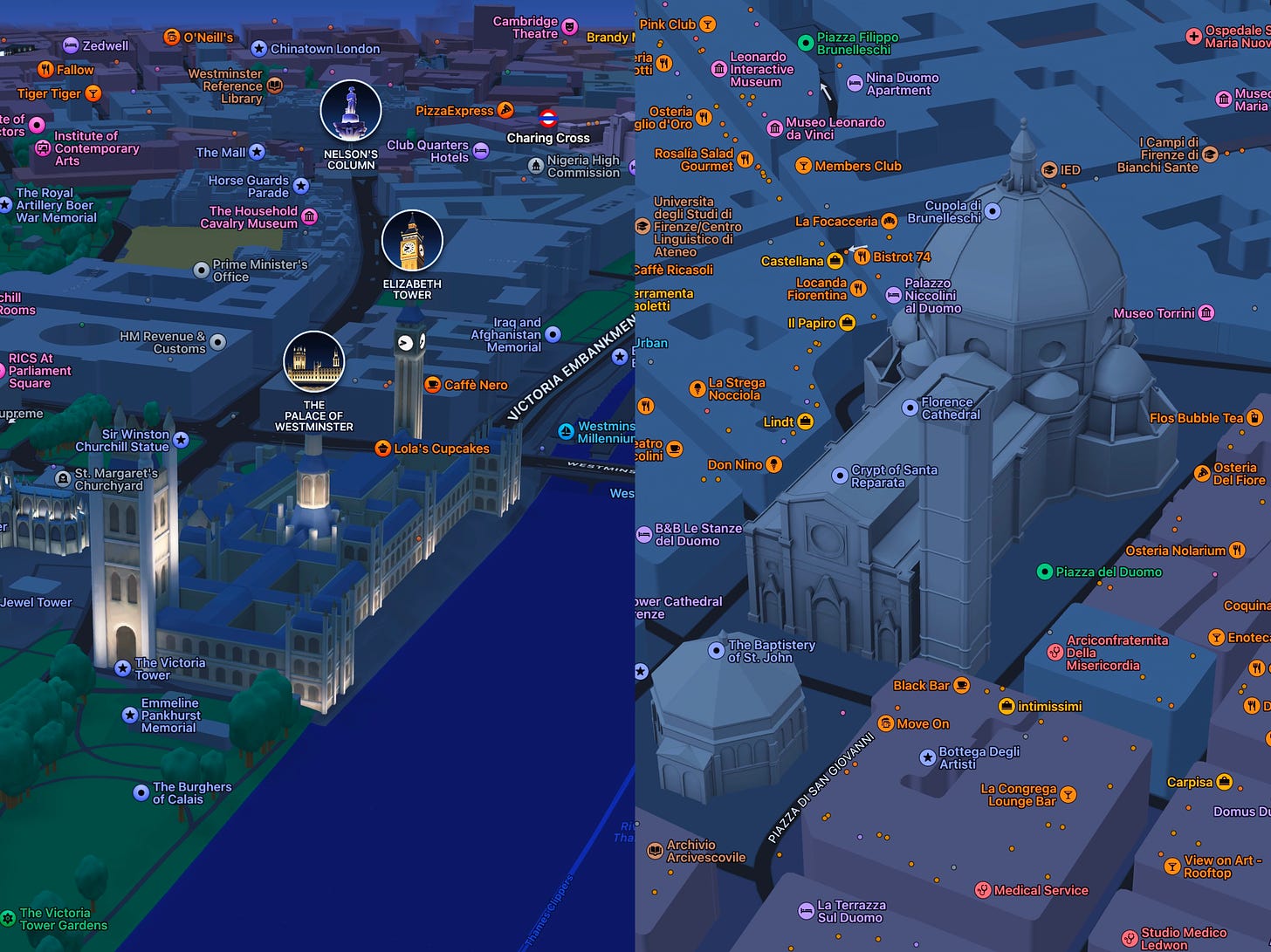

Quello che succede è ciò che io chiamo il fenomeno Apple-Maps-a-San-Francisco.

Se avete un iPhone, provate ad aprire Maps e andate a San Francisco, oppure a San Jose o direttamente ad Apple Park a Cupertino:

troverete dei modelli 3D bellissimi del luogo, dell'aeroporto, di Apple Park con tanto del modellino del palco arcobaleno, oppure il Golden Gate Bridge bello rosso. È super carino!

Ora andate a vedere Roma, o Milano, o Firenze. Il Colosseo vabbè, tutto grigio, ci posso stare;

il Duomo di Milano grigio non è un granché...però Santa Maria del Fiore, e dai coloratemela sta cupola del Brunelleschi no?3

Fatevi un giro a guardare i monumenti in giro per il mondo: la porta di Brandeburgo è tutta bella con le luci e i cavallini, il Big Ben ha tutte le lancette;

la grande piramide di Cheope invece manco ha il modello 3D, che voglio dire, non è che ci vuole sto genio a fare il modello 3D di UNA PIRAMIDE, non so se avete presente...

Questo divertissement per dire cosa: molto spesso certe feature per gli iPhone vengono lanciate prima in California che nel resto del mondo; appunto, le nuove mappe tutte carinelle sono arrivate prima solo a San Francisco, e poi pian piano altrove.4

Il perché è ovvio: Apple è un'azienda californiana, ha facilità a testare le feature sul proprio territorio, e il suo contesto sociale e culturale è quello.

Al momento, tutti i grandi player dell'AI generativa sono in occidente. Beh, anche perché i tool AI cinesi difficilmente li possiamo usare.

Stability AI, che sviluppa Stable Diffusion, è basata a Londra.

OpenAI, che sviluppa Dall-E (e ovviamente anche ChatGPT) è basata a San Francisco, così Midjourney Inc.

Spesso queste aziende raccontano di fare qualcosa di universale, ma la realtà non è assolutamente universale.

Al momento è centrata sugli USA, e sull'occidente; e manco troppo bene, come stiamo vedendo.

Su questo tema torneremo con la prossima lettera...

L'altro spunto di queste disparità è che avvenga una cristallizzazione dei bias, una codificazione delle discriminazioni.

Abbiamo detto che addestrare un modello da zero è costoso e lento: questo crea un altro problema, che prima abbiamo sfiorato. Nel frattempo che come società lavoriamo sui problemi sociali, il modello non si aggiorna da solo.

Se fra un anno in USA per magia sparissero tutte le disparità, Stable Diffusion conserverebbe ancora tutti questi bias, fino a che non lo addestriamo su un nuovo dataset appropriato: naturalmente non avverrà alcuna magia che fa sparire le discriminazioni, ma la staticità di questi modelli fa attrito sul progresso.

Nel pezzo di Bloomberg, Heather Hiles di "Black Girls Code", una no profit che forma ragazze afroamericane nell'ambito tech, dichiara:

Le persone, tramite il vedersi o non vedersi in un contesto, imparano che forse non appartengono a quel luogo. E le immagini rafforzano questo messaggio

Abeba Birhane, scienziata cognitiva che si occupa di Trustworthy AI alla Mozilla Foundation, nell'articolo dice:

Per ogni processo in cui un umano può avere bias, anche le AI possono averne. la differenza è che la tecnologia dà legittimità ai bias facendoli sembrare più oggettivi.

Ne avevamo parlato anche in un reel con Gaia Contu:

le persone vengono influenzate dalle AI, anche quando sanno che si tratti di AI. In generale, abbiamo ancora una visione della tecnologia e della scienza come di qualcosa di puro, oggettivo, sicuro. Se lo dice la tecnologia, ci sembra un po' più vero...ma non lo è sempre.

E dunque?

Sasha Luccioni, ricercatrice ad HuggingFace, nell'articolo dice: 'stiamo imponendo una singola visione del mondo'.

Questo mi riporta in mente il famoso paper Sui pericoli dei pappagalli stocastici di Gebru, Bender et al.

Ne parlammo un po' su Datapizza e Scomodo:

ma magari ci torneremo anche qui o su YouTube, perché ci sarebbe molto da dire.

Uno dei punti centrali del paper è proprio che i grandi modelli di linguaggio possano imporre una visione egemonica sul mondo, in cui vengono cristallizzati i valori e le posizioni prevalenti del dataset scelto come riferimento, che però possono essere discriminatorie.

Sembra, purtroppo, che questo paper facesse nel 2021 una previsione molto accurata di quello che vediamo oggi, sia per i modelli di linguaggio che per l'AI generativa delle immagini. Ma ne riparliamo, dai.

Il pezzo si conclude con una domanda di Luccioni, che si chiede:

di chi è la responsabilità per gestire queste disparità?

Di chi fornisce i dataset?

Di chi addestra il modello?

Di chi lo usa?

A me, personalmente, verrebbe da dire un po' di tutti; i sistemi di AI che abbiamo ora sono il risultato della raccolta dei dati di milioni e milioni di persone, gestiti da tante persone e da aziende con tante risorse.

Non penso si possa individuare un responsabile unico, un Oppenheimer dei sistemi AI (e non che lui fosse solo...) la risposta per me è nel dialogo pubblico, nella documentazione e nella regolamentazione sensata e capace.

Vedremo...

[Newsletter interrotta: c’era un altro pezzo che però rimandiamo sennò diventa ancora di più un pippone infinito]

A proposito di eventi! [Beh, se non fosse stata interrotta avrebbe avuto senso quell’ “A proposito”] questa settimana (giovedì 14) sarò a Trento con un panel al Poplar Cult con Beatrice Petrella del podcast Still Online e moderati da Scomodo;

parleremo di "Vita, morte e miracoli. Quando le AI ti conoscono meglio di tua madre"

È gratis! trovate tutti gli eventi sul sito.

Cosine Belle

📵 AsapSCIENCE ci fa chiedere se siamo dipendenti dai nostri telefoni, mettendoci paura ma dandoci 3 tips per limitare un uso eccessivo. Mi fa un po' paura vedere questi video perché mi sento un po' sotto accusa, ma è utile. Dopo aver visto il video ho ricominciato a usare un'app per controllare meglio il mio uso del telefono. Vi potrebbe interessare se vi parlassi degli strumenti digitali che uso? Ditemi un po'!

🔴 La maggior parte degli ebrei uccisi dai nazisti non è passata per i campi di concentramento. Jacob Arthur ha una serie molto interessante su TikTok sulla Shoah.

🔴 Questa analisi di un TikTok "anti-palestinese". James Ray analizza il video di una studentessa universitaria ebrea che racconta del suo incontro con un vicino di casa palestinese: una volta scoperta la sua provenienza, assume rapidamente un atteggiamento ostile ingiustificato. Ne abbiamo parlato in live su YouTube l'altro giorno!

🧮 Donata Columbro ci racconta che i dati non sono...dati, ma sono creati, e sono un costrutto sociale. E ci dice in 7 punti cosa vuol dire femminismo dei dati. I dati chi li crea? Chi ne ha benefici? E riprende anche i bias delle AI generative di cui sopra.

🇮🇹 Se Tre Uomini e una Gamba fosse doppiato in inglese? italiancomedyclub usa l'AI per doppiare in inglese Aldo Giovanni e Giacomo (o, Giacomow) nella scena della roccia franabile - scusate, friabile -. È inquietante e affascinante: l'umorismo del trio si perde molto in inglese, ma viene creato qualcosa di stranissimo.

🧶 Come non parlare di stupro in televisione. Valentina Mira, scrittrice e giornalista, racconta su Valigia Blu la sua raccapricciante esperienza televisiva. Un'ospite in TV riceve un palco, o diventa un personaggio di cui qualcuno ha scritto il copione e lo deve incasellare lì dentro? È tra l'altro una domanda che mi pongo anche sugli attivisti climatici che vanno spesso in trasmissione con dei negazionisti...chissà.

E anche oggi eccoci qua! Grazie della lettura. Se ti è piaciuta questa lettera, condividila con una persona, o mandale solo un pezzo, che ne so fai qualcosa dai.

Vienimi a trovare su YouTube.

E ci vediamo presto: prossima settimana parleremo del problema delle lingue nelle AI. dell’altra metà della newsletter. 👋

in inglese housekeeper, termine che ho trovato non banale da tradurre, perché viene tipicamente declinato in automatico al femminile: cercando su google c'è "governante" declinato come "la governante", poi "la domestica" o "la massaia".

È chiaro il perché avvenga, ma trovo che sia uno spunto di riflessione.

In inglese i nomi non hanno un genere, ma in italiano sì; la traduzione di Google non può essere neutra, ma riflette una scelta. A voi le conclusioni

Se provate tra l'altro con una AI a generare un "engineer" vi verrà tutta gente con elmetti da cantiere, che in realtà non è la prima immagine di ingegnere che a me verrebbe in mente; magari sono io che ho una visione distorta della popolazione degli ingegneri, ma penso sia un esempio del fatto che più è vago il termine più ci sia varianza nella mente delle persone su come si immaginano quel termine.

Ma poi cavolo cioè colori la porta di Brandeburgo e non i monumenti italiani? Il Colosseo? San Pietro? Santa Maria del Fiore?? Ma l'avete vista Open To Meraviglia?? Allora?? Svegliaaa

E a Roma Apple ancora non mi sa dire le indicazioni per fare un tragitto in bici.