L'AI non è un treno ma una nave, spero.

Ovvero, guardiamoci un attimo intorno rispetto alla narrazione esageratamente catastrofista. Il mio intervento a Visionary Days.

Ciao! Questa è la penultima lettera del 2023, la prossima o quella dopo sarà un numero extra un po’ a parte, ma se questa non la faccio uscire mi perdo i pezzi. Oggi:

Dei pensieri su cosa dobbiamo temere riguardo l’AI, non tanto il futuro quanto già il presente, riprendendo il mio talk a Visionary Days.

Threads, il rivale di Twitter, è sbarcato in Italia! Com’è?

Le app di dating come strumento per scovare insurrezionisti o come si scrive

L'AI è un treno o è una nave?

Ovvero, dobbiamo temere per il futuro? O per il presente?

Il 4 Novembre sono stato ospite a Visionary Days 2023 'Mare in Tempesta'.

una giornata composta da 4 talk e poi da tavoli di discussione sui diversi temi per poi creare un 'manifesto dinamico' che raccolga ciò che si è detto.

Sono sempre contento di partecipare a eventi in cui viene stimolato un dialogo pratico, soprattutto se fatti da/per (/in/con/su/per/tra/fra) giovani.

Siamo il futuro ecc ecc!

Penso sia importante avere spazi di partecipazione e dialogo riguardo lo sviluppo tecnologico e il suo impatto nella società.

Ma basta con il bragging; era la prima volta che indossavo un microfono ad archetto perciò mi sono sentito figo, perdonatemi.

Visionary mi ha chiesto un intervento sull'impatto dell'AI con la cornice narrativa di un mare in tempesta, quindi mi sono chiesto: dove sta la tempesta? E dove siamo noi?

Si sente parlare spesso di una tempesta all'orizzonte: l'AI ci ruberà ogni lavoro, l'AI ci ucciderà tutti, l'AI mi ha rubato lə fidanzatə, chi più ne ha più ne metta.

Io penso che al momento non è così: penso che dobbiamo stare più tranquilli sul futuro...per spaventarci di più sul presente. Sennò il talk non poteva chiamarsi 'Tempesta' no?

PS: potete vederlo su YouTube!

Riguardo il futuro penso, e non sono il solo, che i cosiddetti 'doomer' che vedono nell'AI dei rischi 'esistenziali' stiano di fatto guardando alla fantascienza più che a degli orizzonti realistici.

Il nostro cervello è bravissimo a farci vedere una intelligenza anche se non c'è, come quando guardi una macchina e ci vedi degli occhi nel muso, ma di sicuro quell'auto non è intelligente.

Noi umani poi comunichiamo tantissimo tramite il testo...insomma, anche se non ci fossimo mai visti dal vivo, è educato presupporre che io che scrivo sia una persona reale e non una macchina, no? (Non uso nemmeno ChatGPT per scrivere questi testi, pensate)

Come viene scritto in Stochastic Parrots, uno dei miei paper preferiti sul tema: 'Coherence is in the eye of the beholder', la coerenza che ci vediamo negli output di ChatGPT non esiste di per sé, ma siamo noi a vederla.

Il modello fa un lavoro statistico, ma non ha cognizione:

noi umani quando parliamo o scriviamo abbiamo un preciso intento comunicativo, un contesto condiviso, e appunto una cognizione di ciò che stiamo dicendo.

ChatGPT no, ma siccome è un sistema sofisticato azzecca i segni grafici che poi siamo *noi che leggiamo* a interpretare come coerenti.

Insomma, un po' come se il biscotto della fortuna che leggi dopo il sushi ti dicesse qualcosa di vero su di te, questo non vorrebbe certo dire che chi l'ha scritto ti conosce.

(C'è da dire che in realtà ChatGPT parte effettivamente da un input che gli diamo noi, mentre il biscotto della fortuna parte solo dall'input di sushi verso la nostra bocca).

Tutto ciò per dire che ci sono una serie di fattori e meccanismi per cui siamo spinti a vedere una fantomatica AGI, intelligenza artificiale generale, ben più vicina rispetto a quello che effettivamente i sistemi di oggi sanno fare.

(E poi, mi permetto di vedere con un po’ di malizia anche un pizzico di marketing subdolo che spinga a dire ‘uh, quanto sono potenti questi strumenti!’)

Perché però sarebbe un problema preoccuparsi della fantascienza? Non è affascinante e utile per il futuro ragionare su quello che potrebbe succedere, anche se ci sembra potenzialmente lontano o improbabile?

Sì, ma no, perché ovviamente l'attenzione collettiva è limitata.

Se parliamo pubblicamente solo di superintelligenze killer, rischiamo di monopolizzare lo spazio e l'attenzione sul tema e far dimenticare i concreti e attuali problemi dei sistemi AI.

Insomma, la tempesta, secondo me, non è un cataclisma futuro, ma ci siamo già dentro.

Nel talk faccio l'esempio parlando di un paio di bias di ChatGPT e di Stable Diffusion:

Il primo esempio è quello della lingua: ChatGPT viene presentato come utile in tantissime lingue, e tutto sommato in italiano funziona molto bene.

Potrebbe farci pensare che non ci sia nessuna differenza tra usarlo in italiano o in inglese o in qualsiasi altra lingua, ma la realtà è che ChatGPT è senza dubbio più capace a generare testo in inglese rispetto a tutte le altre lingue.

Per accorgervene, provate a chiedere a ChatGPT di generare delle battute in italiano e di spiegarvele; io l'ho fatto un po' di tempo fa su Datapizza:

Ecco un altro paio di esempi:

ho fatto cherry picking, ma qui vedete la conversazione intera e potete divertirvi:

Il mio sospetto è che quelle che hanno senso siano semplicemente state memorizzate dai dati di training, le ripete molto spesso.

Ok ma tutto questo che c'entra con i bias?

Abbiamo capito che ChatGPT non parla tutte le lingue allo stesso modo: per l'italiano ci va ancora bene, ma se prendiamo una lingua etiope come l'amarico il risultato è che fa enorme difficoltà.

Ecco, anche questo è digital divide: questi strumenti che ci possono sembrare universali in realtà ancora una volta funzionano meglio per noi, che siamo una parte privilegiata della popolazione mondiale.

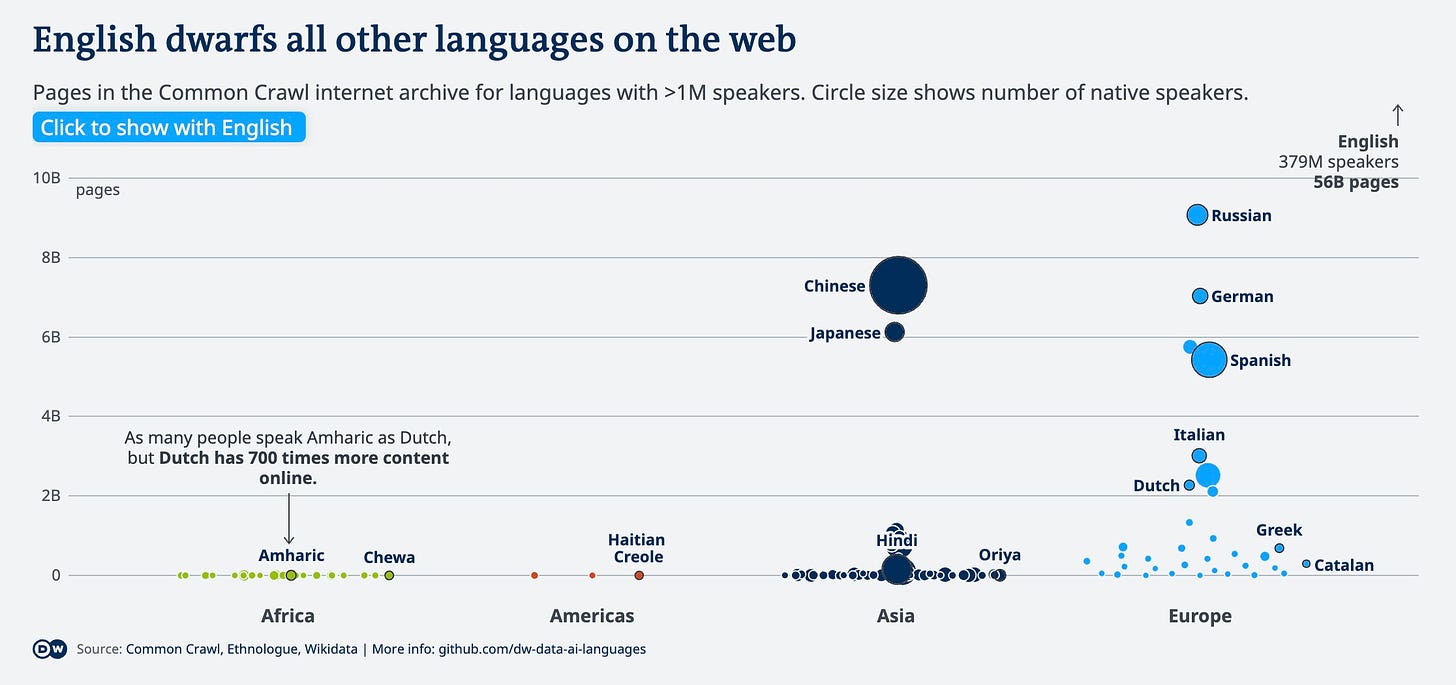

Il motivo è che noi partiamo da un altro privilegio precedente: quello di avere tanti dati digitalizzati. Prendiamo l'olandese, che ha 23 milioni di parlanti, come l'amarico: la prima però ha 700 volte più testi digitalizzati della seconda nel Common Crawl, che è un grande database di internet spesso usato per addestrare sistemi AI.

Raccogliere e usare i dati non è una operazione neutra, e quando facciamo finta di fare dei modelli 'universali' in realtà rendiamo invisibili tutta una serie di situazioni minoritarie.

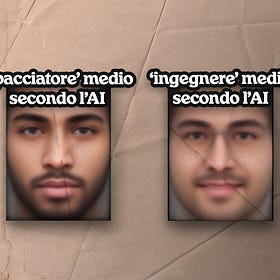

Per parlare invece dei bias nelle immagini vi rimando a un numero precedente in cui ne avevamo parlato meglio:

Quindi come risolviamo? Per come la vedo, abbiamo due strade da percorrere in parallelo:

la prima è valutare con più attenzione la selezione dei dati con cui addestriamo i modelli, e in questo una maggiore trasparenza sui dataset dei grandi modelli sarebbe utilissima (I'm looking at you, "Open"AI).

[addendum dell’ultimo minuto: proprio pochi giorni fa è uscito un grosso problema su LAION-5B, uno dei database di immagini più usati per le AI, prossimamente ne parleremo meglio]

Il secondo è quello di sviluppare forse anche dei modelli più piccoli e più locali, addestrati con dati locali rilevanti, e rendersi conto che non sempre 'l'universale' è veramente tale.

Concludo tornando sull'evento in sé: è stata una figata!

Ringrazio tanto i ragazzi di Visionary per l'invito e l'enorme lavoro che hanno fatto, e invito tutte e tutti a partecipare e creare occasioni di dialogo collettivo di questo tipo, perché, per tornare all'inizio, penso che l'AI e in generale le tecnologie non siano un treno, nel senso che non vanno per una strada già determinata.

Ci vedo più su una nave:

siamo in movimento, certo, e non possiamo rimanere fermi,

ma possiamo decidere noi la direzione e chi tiene il timone:

siamo noi che possiamo decidere se la direzione che prendiamo

esclude qualcuno oppure no,

se è a beneficio di tutte e tutti oppure no,

quindi scegliamo bene la rotta.

Threads è arrivato in Italia, davvero

Threads, il rivale di Twitter di Meta, è sbarcato anche in UE, e dunque anche in Italia. Per ora io mi sto divertendo un sacco!

Mi piace avere un luogo basato sul testo che sia meno formale di questa lettera e di LinkedIn.

Nell’ultimo periodo ho usato molto Twitter, nonostante tutti i problemi, perché ci ricavavo ancora tanto: molti giornalisti e ricercatori di cui seguo il lavoro sono su Twitter, e un po’ di funzioni realmente utili ci sono, tant’è che sto anche pagando il premium per avere i ‘top articles’ (una lista di articoli condivisi di più tra i propri contatti) e i segnalibri categorizzati. Spero che Threads aggiunga al più presto feature, API, e soprattutto che la gente passi a Threads o a Mastodon, così posso definitivamente salutare Twitter. Ultimamente ho speranze per il fediverso, staremo a vedere.

Ma se volete sentirmi parlare di più e fare due chiacchiere sui politici italiani che arrivano su Threads, potete recuperare la diretta che ho fatto con Beatrice Petrella! (PS ditemi se vi piacciono queste chiacchierate così o se fareste qualcosa di diverso).

Cosine belle

💌 Come usare Bumble per trovare insurrezionisti e consegnarli all’FBI: una storia immensamente divertente.

🚀 John Oliver parla di Musk su Last Week Tonight, una bellissima puntata sul nostro amichetto di Atreju preferito

🧵 Ho guardato l’intervista di Nicola Porro a Musk ad Atreju, così non lo dovete fare voi, let me know se vi piace questo formato

📸 Guardate gli scatti incredibili di questo fotografo! Allora c’è qualcosa che l’AI ancora non può fare dai…

Bene, e anche oggi ci siamo. Come sempre, grazie per la lettura.

Ci vediamo dopo natale su questi lidi, forse anche per parlare proprio dei lidi di Substack.

Buone feste, e ciaone 👋❤️