ChatGPT sta diventando più stupido, o forse siamo noi.

Ovvero la difficoltà di raccontare il progresso.

Oggi:

riprendiamo una notizia di qualche settimana fa su un presunto peggioramento di chatGPT, per riflettere come raccontiamo l’hype, anche per il caso del superconduttore.

Capiamo cosa c’entrano le AI e il progresso con una divinità romana.

Elon getta definitivamente la spugna sul combattimento.

Come vendere la propria startup per 100 milioni in pochi semplici passaggi.

PS: Questi giorni sono/sono stato a L’Aquila per il perdonanza village e ho partecipato a un bel panel sull’AI, ma ne parleremo nella prossima lettera, così ho tempo di digerire le emozioni e i pensieri. Beh iscriviti per non perderla insomma dai su.

Qualche settimana fa ci chiedevamo se ChatGPT stesse peggiorando rispetto al passato. La domanda era scaturita da un esperimento di Matei Zaharia, Lingjiao Chen e James Zou, che hanno fatto dei test confrontando le versioni di marzo e giugno di GPT-3.5 e GPT-4.

Dai loro risultati la conclusione sarebbe di cambiamenti sensibili tra le due versioni, e in particolare addirittura una degradazione nelle versioni più recenti.

Questo risultato è rapidamente diventato notizia, sia perché..beh è interessante, ma anche per un altro motivo: perché confermava un'intuizione diffusa.

È pieno da un po' di commenti online che ipotizzano un peggioramento di GPT-4, al punto che Peter Welinder, VP of Product a OpenAI, aveva twittato smentendo l'ipotesi. (Ci torneremo)

Insomma, non appena è uscito il paper, tutti sono corsi con dei titoloni su ‘ChatGPT è peggiorato’ ‘ChatGPT è diventato più stupido’. Un titolo estremamente ghiotto.

Il problema è che questo paper non sembra essere così determinante:

ho trovato molto interessante l'analisi del professor Arvind Narayanan e Sayash Kapoor in cui commenta la metodologia e si testano nuovamente le richieste a GPT fatte nel paper:

La conclusione importante è che secondo Narayanan e Kapoor quello che emerge non è una "degradazione" delle capacità di ChatGPT quanto più che altro un cambiamento di comportamento del modello, ma anche che alcuni esempi del paper erano scelti non proprio benissimo.

Mi permetto di annoiarvi un pochino con i dettagli di un esempio specifico, se non vi interessa skippate avanti.

Un esempio noioso

Nel paper si valuta la capacità di ChatGPT in matematica, e in particolare nel riconoscere numeri primi, dicendo che nella build più recente sia peggiorato.

Giusto per essere sulla stessa pagina, un numero intero è primo se si può dividere solo per se stesso e per 1, altrimenti lo chiamiamo composto. 3 è primo, 12 è composto infatti 12 si può dividere per 3 e per 2.

I numeri scelti per il test del paper però erano tutti primi, e questo è un problema.

Secondo Narayanan e Kapoor infatti ChatGPT spesso non effettua davvero un controllo sui numeri, ma dà solo la risposta in modo arbitrario.

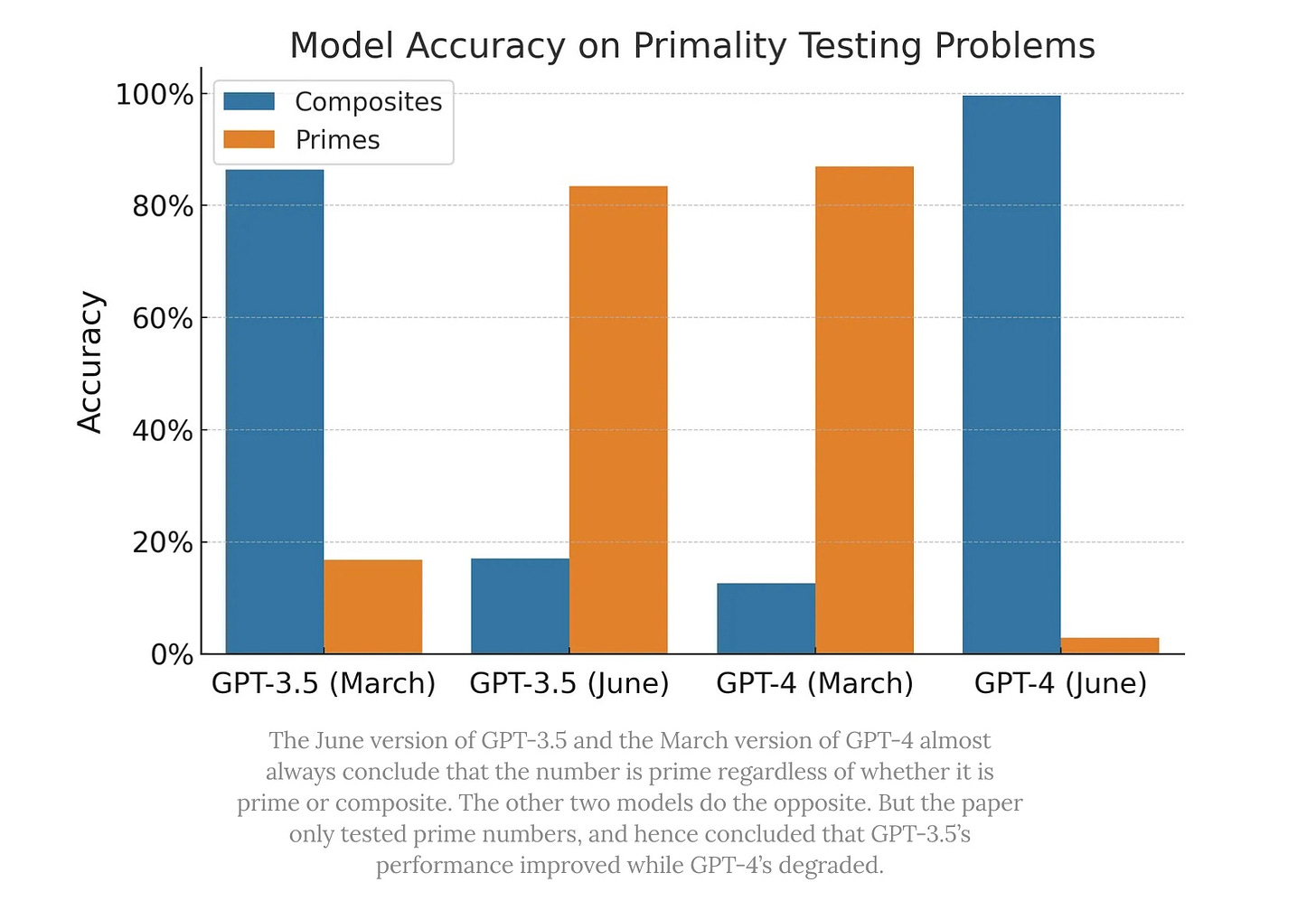

Testano quindi con dei numeri composti (ovvero non primi), e ottengono questo:

Da questo grafico vediamo che GPT-3.5 nella build di marzo ipotizza quasi sempre che i numeri siano composti, mentre nella versione di giugno quasi sempre che siano primi: se gli diamo un numero composto (blu) infatti avrà sempre quasi ragione per la build di marzo e quasi sempre torto per la build di giugno.

Per GPT-4 è il contrario: la build di marzo ipotizza quasi sempre che siano primi, mentre quella di giugno quasi sempre che siano composti.

GPT non sta veramente valutando se i numeri sono primi o meno, semplicemente in qualche modo ha un fine tuning che fa dire più spesso o che siano primi o che siano composti al di là del numero.

Se però gli diamo solo numeri primi potremo far sembrare che GPT-4 sia peggiorato molto. GPT-3.5 invece su questo task sembra “migliorare” se selezioniamo male gli esempi, anche nessuno ha scritto “GPT-4 è diventato più stupido e GPT-3.5 più intelligente”

Fine dell’esempio noioso

Quindi, ChatGPT sta peggiorando? Boh? Forse questo studio non ci permette di dirlo.

Penso però ci permetta di dire qualcosa di importante sulle AI e su come le raccontiamo:

Sulle AI, ci dice che dobbiamo sempre tenere a mente la volatilità dei modelli di linguaggio e del continuo fine-tuning: Il modo in cui chiedi a GPT qualcosa oggi potrebbe non funzionare quest’inverno; in parte una maggiore trasparenza da OpenAI potrebbe aiutare a riguardo, e in parte è quasi intrinseco ai correnti sviluppi di questi modelli. Vediamo come va.

Quello che secondo me è molto interessante è che ci dice qualcosa su come raccontiamo il progresso:

Su LLM e AI c'è un enorme hype. Dicevamo che saremmo tornati al VP di OpenAI: la sua ipotesi è che GPT-4 potrebbe sembrare peggiorato perché usandolo di più e/o più a lungo ci si rende conto delle sue limitazioni.

All’uscita del modello l'hype era alle stelle, al punto da suscitare le famose letterine “smettiamo di sviluppare le AI!” o i vari “Le AI ci uccideranno tutti!”

Forse pian piano stiamo capendo che è GPT-4 che non fa le magie come pensavamo. Non sei tu, sono io. GPT-4 non ‘pensa’, non è ‘cosciente’, nulla di tutto ciò.

E forse faremmo meglio a valutare con occhio più critico dei sensazionalismi eccessivi. Non perché gli LLM o le AI generative non stiano portando dei cambiamenti, ma proprio per valutarne meglio gli effetti e le capacità e non banalizzarne difetti e rischi presenti e futuri.

Un po’ come è successo per la vicenda del superconduttore. Non so nella vostra bolla, ma nella mia erano (eravamo) tutti in hype per il fantomatico LK-99.

In parte, entusiasmo motivato: avere dei superconduttori a condizioni standard di temperatura e pressione ci aprirebbe allo sviluppo di tantissime cose.

Però mi ritrovo con questo thread del buon Massimo Sandal:

La red flag [per presupposte scoperte scientifiche] è una combinazione di:

dati scadenti, incompleti o altrimenti non ferrei

risultati che escono inaspettatamente, non all'interno di un robusto programma di ricerca

nessuna replica dei risultati prima degli annunci

promessa di un enorme progresso fondamentale o pratico (spesso entrambi)

Si noti che, di per sé, nessuno di questi è un problema significativo; molti risultati scientifici reali soffrivano di uno o due di questi elementi.

Il problema è che, quando sembra che stia accadendo qualcosa di straordinario, vogliamo credere che sia successo davvero. Ed è molto facile trascurare i dettagli banali, noiosi e sporchi che destano sospetti quando c'è una tale promessa.

Il fatto che un superconduttore a temperatura ambiente sia così ghiotto dovrebbe automaticamente farci interrogare più a fondo, perché la tentazione di farsi prendere da un entusiasmo prematuro è fortissima. Tutti vorremmo una soluzione chiara e immediata ai problemi del mondo, no?

Ecco. Con i superconduttori ci siamo lasciati trascinare dall’entusiasmo, evidentemente in modo prematuro. Questo ci deve far domandare, come scrive Gary Marcus: sulle AI generative rischiamo di ripetere lo stesso errore?

È una domanda che anche uno come me che usa le AI generative quotidianamente si deve porre.

GPT non è una magia, anche se vogliamo che lo sia; diamogli la dignità da strumento innovativo e utile, ma non magico, che si merita. Diamogli la dignità di essere una macchina utile per determinati usi, e non per ‘qualsiasi cosa’. E diamo la giusta dimensione ai timori sul suo uso, senza rischiare di essere noi stessi ad alimentare il caos.

Perché dire che le AI ci uccideranno tutti crea l’immagine cognitiva che ChatGPT abbia una volontà, e non che sia solo un sintetizzatore di testo.

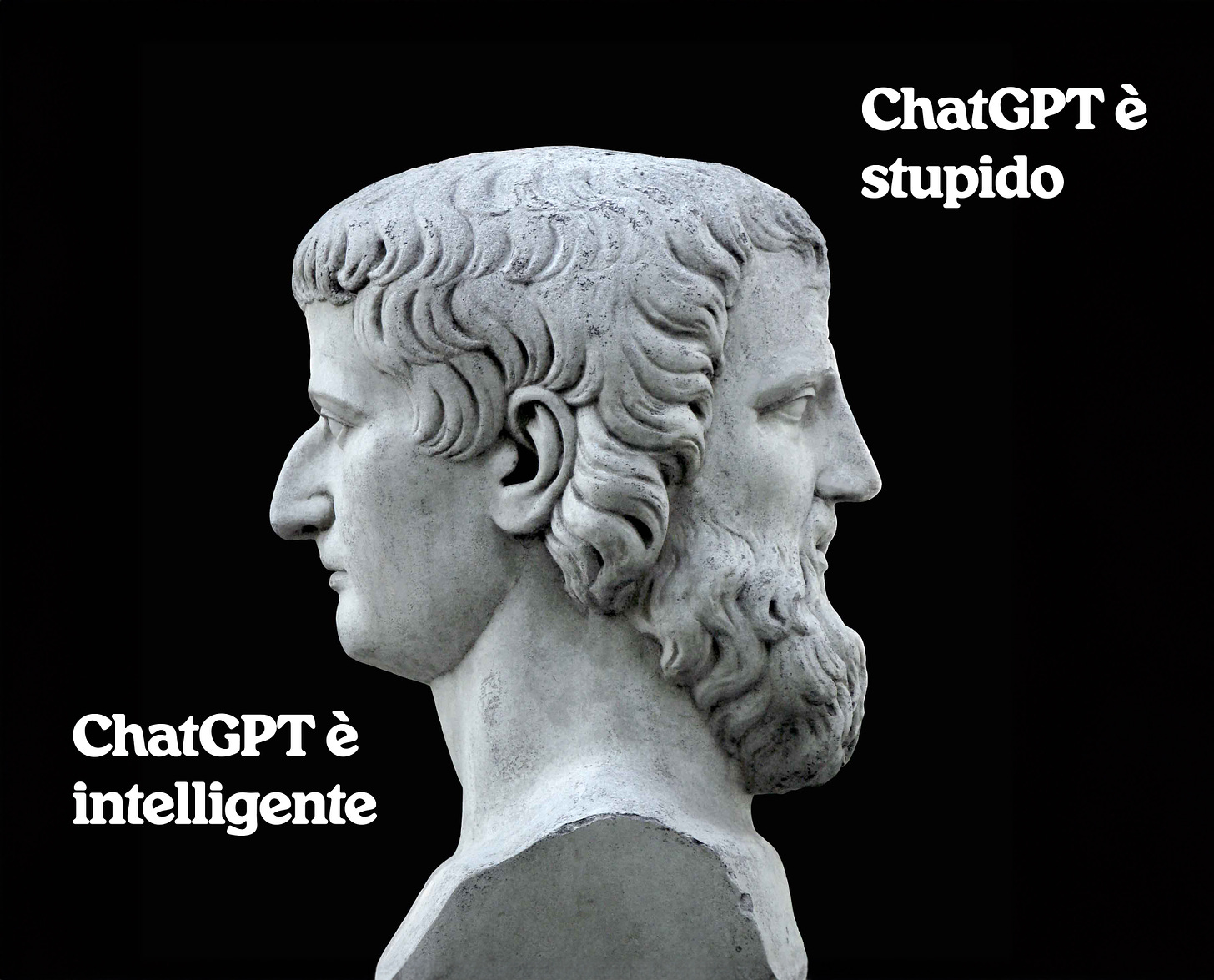

Giano bifronte

Questo giro molto veloce di news ha porta anche a una discussione attiva altrettanto veloce: in meno di 24 ore abbiamo avuto quasi una peer review pubblica del paper, figo! Una cosa simile è avvenuta anche per il superconduttore.

Il problema è…quanti di quelli che hanno messo i titoloni “ChatGPT è diventato più stupido!” hanno aggiunto poi delle analisi più approfondite e critiche sul paper?

Qualcuno anzi ha postato questo titolo sensazionalistico settimane dopo l’uscita e ha preso il paper acriticamente senza indagare in alcun modo. Dobbiamo fare di meglio, perché parlare delle cose in divenire non è facile.

A tal proposito, vi rimando a uno stupendo post della cara lametascienza.

Bruno Latour era uno studioso di STS (Science and Technology Studies o Science, Tecnology and Society) una branca interdisciplinare che studia la scienza e la tecnologia nel loro contesto storico e sociale.

Latour descrive la scienza come Giano Bifronte, la divinità romana con due facce. Una faccia è quella della ‘Scienza pronta all’uso’: sono tutte le conoscenza scientifiche e tecnologiche assodate, di cui il consenso è sedimentato e siamo tutti d’accordo senza metterle in discussione. La terra è tonda. Il sole sorge ad est. Il DNA ha una struttura a doppia elica. Il tè alla pesca è meglio di quello al limone.

L’altra faccia è la ‘Scienza sul farsi’: è la conoscenza scientifica che stiamo ancora costruendo, testando, su cui abbiamo conflitti, ed è normale che sia così proprio perché dobbiamo ancora capire. Le conversazioni che abbiamo sulle AI e sul progresso, e sui superconduttori, potremmo metterle su questa faccia qui di Giano.

Il problema sorge quando ci aspettiamo la solidità e la folta barba di Giano Ready Made ma stiamo invece parlando con il glabro Giano In The Making, quando pretendiamo che Giano sia subito Pronto all’Uso. La barba ci mette un po’ a crescere, e siamo noi società a direzionare il pelo. Quando parliamo del Giano senza barba dobbiamo anche avere attenzione su come si evolve la situazione, e non prenderla per già determinata. 🧔🏻

Elon getta la spugna

Ovviamente dopo l’uscita della mia lettera a riguardo perché figurati se non potevo aspettare un attimo, Musk ha chiuso definitivamente la questione combattimento.

Ha risposto a Sangiuliano con vari salamelecchi e ha promosso la sua visione secondo lui sarebbe Zuckerberg a tirarsi indietro, e non lui. A voi la sentenza.

Una cosa però la dico: Musk, senza aver concretamente fatto niente e donato nulla a nessuno, ha collegato alla sua figura quella di un filantropo che vuole bene ai bambini malati e ai veterani. L’evento non si fa, quindi niente donazione, però ci può far pensare che lui questa donazione la avrebbe fatta perché è buono.

Bravo Musk. Nel frattempo, in altre notizie, Twitter avrebbe cancellato un fact check delle Community Notes fatto a Musk. E il professor Galloway avrebbe avuto l’account bloccato dopo aver declinato un incontro con Musk.

Cosine belle

🌭 Un’opera d’arte fatta con l’acqua degli hot dog. Questo video è bellissimo e l’opera mi piace un sacco. È estremamente inutile e dall’apparenza finale così piatta, ma nasconde un processo divertentissimo.

🪴 La figura barbina di Europa Verde che cancella dei tweet su Finlandia e Svezia quando le Community Notes di Twitter fanno notare che i due stati usano l’energia nucleare. Anche senza dare una connotazione di partito, che non mi frega, trovo interessante il fatto che le feature di un social si siano ritorte contro chi postava. Dopodiché, le Community Notes hanno tantissimi problemi, non so ancora dire se siano un buono strumento.

🎤 Donald Trump canta Summertime Sadness…no aspetta, è una AI, ma è super orecchiabile.

💰 Una guida step by step per creare una startup AI e venderla per 100 milioni. Lo step 3 è importantissimo.

Che dire, grazie della lettura! Condividete questa lettera con qualcuno se vi è piaciuta, o se non vi è piaciuta lamentatevene pubblicamente ma citando il nome e il link così mi arriva gente.

E ci vediamo presto!